Deepfake; kun je nog geloven wat je ziet?

Een Russische nepdissident voerde vorige week via Zoom een geanimeerd videogesprek met enkele Kamerleden. Ze meenden de echte Leonid Volkov, stafleider van de Rus Aleksej Navalny, voor zich te hebben. Zo levensecht is deepfake. En dit is nog maar een begin.

Kamerleden communiceren via live-communicatieprogramma’s Teams en Zoom gemakkelijk met buitenlandse dissidenten. Kennelijk zijn ze daarmee ook eenvoudig te bedriegen. Hoe weten ze wat echt is en wat nep? Valt waarheid nog van leugen te onderscheiden?

Dat een foto de waarheid niet per se hoeft weer te geven, is bekend. De nazi’s gumden al ongewenste personen weg uit staatsiefoto’s. Met het computerprogramma Photoshop is dat nog simpeler.

Bewegend beeld is lastiger te manipuleren. Maar met kunstmatige intelligentie blijkt ook dat mogelijk. Aanvankelijk werd die gebruikt om bekende personen in diskrediet te brengen. Bijvoorbeeld door hun hoofd te plakken in pornofilms.

De eerste pogingen om bewegend beeld te manipuleren waren overduidelijk nep. Inmiddels is echt al bijna niet meer van nep te onderscheiden. Sommige toepassingen van deze techniek lijken onschuldig. Zo is het mogelijk overleden personen tot leven te brengen in videobeelden. Zelfs geschilderde mensen kunnen tot leven worden gewekt met ”deep nostalgia”.

Deepfakes zijn niet alleen onschuldig. Soms zijn ze ronduit schadelijk. In deepfakes kunnen kwaadwillenden iemand alles laten zeggen wat ze maar willen. Zo ging in 2017 op YouTube een video viraal waarin Barack Obama opzienbarende uitspraken deed. Maar de video was nep; gemaakt met behulp van kunstmatige intelligentie.

Geweld

Er gaan deepfakevideo’s rond in ontwikkelingslanden die aanleiding zijn voor levensecht geweld. „Dat is een reëel gevaar”, zegt Aviv Ovadya, hoofdtechnoloog sociale media van de universiteit van Michigan op de website van het Massachusetts Institute of Technology. „Welkom in een toekomst waarin kunstmatige intelligentie krachtig genoeg is om mensen dingen te laten zeggen die ze nooit hebben gezegd en dingen te laten doen die ze nooit hebben gedaan”, schrijft Schick.

Dit is waarschijnlijk nog maar het begin van een wereld van videovergaderen waarin niemand er meer voetstoots vanuit kan gaan „dat degene die in een vergadering zit ook degene is voor wie hij zich uitgeeft”, zei Tech-trendwatcher Jarno Duursma maandag in de Volkskrant. Nepnieuws en complottheorieën krijgen er nieuwe dimensie bij. Schick: „In ons kapotte informatie-ecosysteem, gekenmerkt door verkeerde informatie en desinformatie, zijn deepfakes de nieuwste dreiging.”

Zijn in zo’n toekomst echte beelden nog van nepbeelden te onderscheiden? Voor de gemiddelde leek waarschijnlijk niet. Alleen door zorgvuldig navragen, is te achterhalen of met de echte persoon gesproken is of niet.

In het ergste geval kunnen deepfakes een ”infocalyps” veroorzaken: een toestand waarin de verwarring compleet is, omdat mensen niet meer kunnen geloven wat ze zien. Schick: „Iedereen kan worden aangevallen en iedereen kan alles ontkennen.” Deepfake-onderzoeker Henry Ajder maakt zich daarover grote zorgen. „De dag dat niemand nog onderscheid kan maken, zitten we pas echt diep in de problemen.”

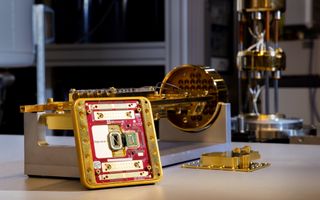

Mogelijk kan de techniek een handje helpen om nepbeelden te ontmaskeren. Momenteel werken softwaregigant Microsoft en het Amerikaanse onderzoeksinstituut Darpa aan kunstmatige intelligentie die moet achterhalen of een video echt is of nep. „Het is een wapenwedloop”, aldus Walter Scheirer van het Darpa-project.

Wat is waarheid? De vraag die Pontius Pilatus eens stelde, is in het huidige digitale tijdperk actueler dan ooit.